Terapias con robots para ayudar a los niños autistas

Un ambicioso proyecto científico persigue el objetivo de que los niños autistas adquieran la capacidad de entender y expresar mejor sus emociones gracias a los robots. Así, un equipo internacional de investigadores ha desarrollado un sistema de aprendizaje automático que permite que los androides se relacionen con cada menor de edad a partir de datos recopilados, analizados y tratados exclusivamente para ese paciente.

Gracias a este método, denominado deep learning, las valoraciones de los dispositivos artificiales coinciden en un 60% de veces con los dictámenes de los terapeutas humanos. Sin embargo, el objetivo a largo plazo no es crear robots que sustituyan a los médicos, sino que se complementen perfectamente entre sí, destaca uno de los autores de este estudio, Ongjen Oggi Rudovic.

Una colega suya, Rosalind Picard, que subraya la relevancia de la “personalización” en estas terapias, señala: “En la inteligencia artificial, se requieren grandes cantidades de datos que son similares para cada categoría, no obstante, en el caso del autismo, donde predomina la heterogeneidad, el enfoque tradicional fracasa”. El deep learning, que se ha aplicado con éxito para reducir el dolor y para pronosticar la progresión de enfermedades como el Alzheimer, funciona en este supuesto con fotografías y tarjetas.

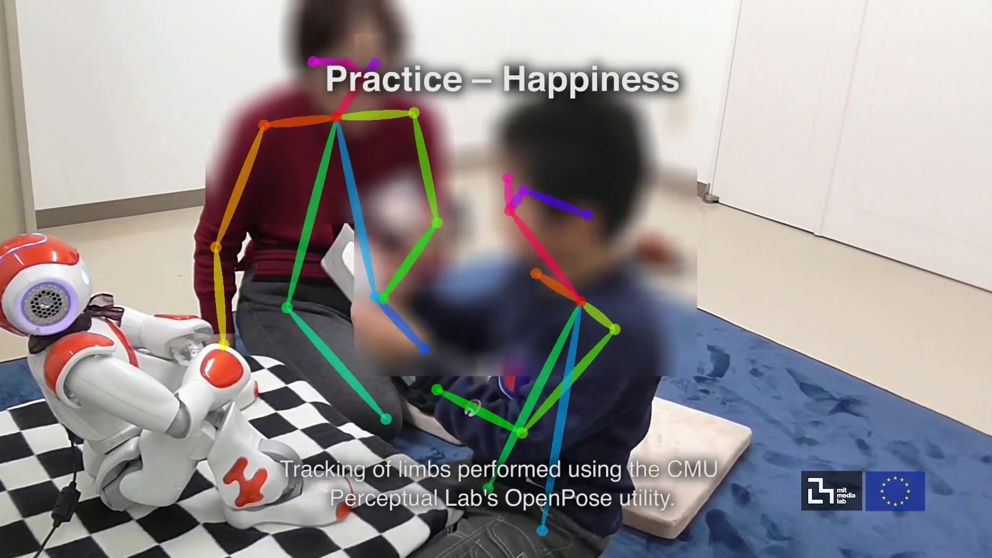

Los doctores les muestran a los robots imágenes de niños experimentando distintas sensaciones y estados de ánimo: miedo, tristeza, alegría… A continuación, el humanoide, en esta ocasión, NAO, de SoftBank Robotics, es programado para que manifieste estas mismas emociones. Lo hace, bajo la atenta mirada de los técnicos de carne y hueso, cambiando el color de sus ojos, el tono de su voz, el movimiento de sus extremidades, etc.

Entre los 35 chavales que intervinieron en las pruebas, 18 serbios y 17 japoneses, con edades comprendidas entre los 3 y los 13 años, hubo reacciones de todo tipo: risas, aplausos, entusiasmo… pero también aburrimiento e incluso somnolencia. La mayoría de ellos se vinculó al robot, no como a un juguete, sino como a una persona real, en especial, durante la lectura de cuentos. El llamado aprendizaje profundo, utilizado en el reconocimiento de voz y objetos, ayuda a dar sentido a las características de los rostros.

En el deep learningse usan capas de información, ordenadas jerárquicamente, y múltiples procesamientos de datos para mejorar estas tareas. Para la máxima eficiencia de la fórmula, financiada de manera conjunta por las administraciones europea y japonesa, se han considerado poses y gestos, la frecuencia cardíaca, la temperatura corporal, la sudoración, etc. de los escolares seleccionados.

DC / La Vanguardia